您是否曾有过这样的经历:在观看一场期待已久的直播时,画面却突然变得模糊不清,充满了恼人的马赛克?或者在刷短视频时,因为视频画质低下,精美的风景和动人的瞬间都大打折扣?在移动互联网时代,视频已经成为我们生活的一部分,但网络波动、设备性能限制以及视频压缩等因素,常常导致我们看到的画面不尽如人意。然而,随着人工智能技术的飞速发展,一场关于视觉体验的革命正在悄然发生。如今,强大的AI画质修复技术正被集成到短视频和直播SDK中,它就像一位随身的“画质魔法师”,能够实时地将那些模糊、昏暗、充满噪点的视频变得清晰、生动,为我们带来前所未有的高清视觉享受。

AI修复画质的核心原理

AI画质修复技术并非单一的技术,而是一个集成了多种深度学习算法的综合解决方案。它的核心思想是利用算法“脑补”出视频在压缩或传输过程中丢失的细节信息,从而从根本上提升感官体验。这与传统滤镜或锐化工具那种简单粗暴地调整画面参数的方式有着本质区别。

智能超分辨率技术

超分辨率(Super-Resolution, SR)技术是AI画质修复中最令人惊艳的一环。简单来说,它的目标就是将低分辨率的视频“放大”成高分辨率的视频,同时还要保证画面清晰自然。试想一下,把一张小尺寸的模糊照片强行拉大,结果一定是模糊的色块和明显的锯齿。传统的插值算法(如双线性和双三次插值)就是这么做的,它们只能根据像素点之间的数学关系来填充空白,效果差强人意。

而AI的玩法完全不同。它通过深度学习模型,特别是生成对抗网络(GAN),来学习海量的高清与低清图像对。在这个过程中,AI模型不断地学习如何从一个模糊的图像块中,推断并“画”出它原本应该有的高清细节和纹理。它不是在猜测,而是在基于大数据学习到的规律进行合理创作。因此,经过AI超分辨率技术处理的视频,不仅分辨率更高,连人物的毛发、建筑的纹理等细节都能被清晰地重建出来,效果非常惊人。

智能降噪与去伪影

在光线不足的环境下拍摄,或者视频经过多次压缩传输后,画面中常常会出现两种“污染物”:噪点(看起来像随机分布的雪花点)和压缩伪影(通常表现为方块状的马赛克)。传统的降噪算法往往难以区分噪点和画面本身的细节,在去除噪点的同时,也会让整个画面变得模糊,得不偿失。

AI智能降噪技术则要聪明得多。通过训练,AI模型能够精准地识别出哪些是真正的噪点和伪影,哪些是画面应有的细节。它在处理时会像一个经验丰富的修复师,小心翼翼地抹去噪声,同时对被噪声覆盖的细节进行智能填补。这样一来,既能保证画面的纯净度,又不会牺牲清晰度,尤其在夜间直播或观看老旧视频时,这种技术的优势体现得淋漓尽致。

| 功能维度 | 传统图像处理方法 | AI画质修复技术 |

| 超分辨率 | 基于插值算法(如双三次插值),效果模糊,边缘有锯齿。 | 基于深度学习(如GAN),能生成逼真的细节和纹理,边缘锐利。 |

| 降噪处理 | 使用高斯滤波等方法,容易导致画面整体模糊,细节丢失。 | 智能识别噪声与细节,精准去除噪声,同时保护甚至增强细节。 |

| 色彩增强 | 全局调整对比度、饱和度,可能导致颜色失真或过饱和。 | 基于内容理解进行局部和全局的色彩调整,效果更自然、生动。 |

| 适应性 | 算法固定,对不同场景和类型的视频处理效果差异大。 | 模型具有强大的泛化能力,能自适应处理各种复杂的视频场景。 |

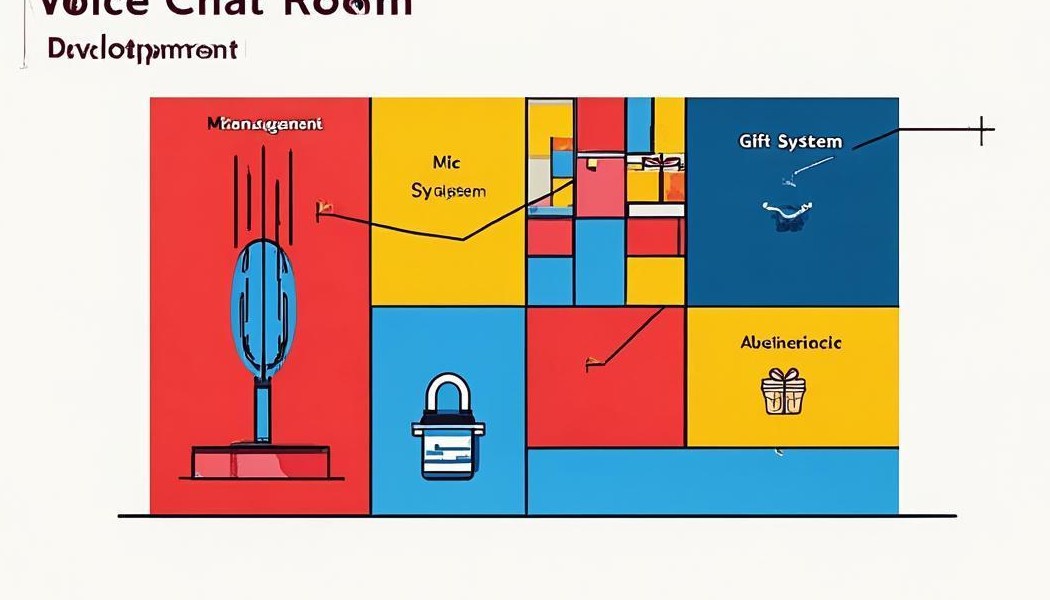

SDK集成与工作流程

如此强大的技术,听起来似乎非常复杂,普通的应用开发者要如何才能使用上呢?答案就是通过SDK(Software Development Kit,软件开发工具包)。一个优秀的SDK会将这些复杂的AI算法封装成简单易用的接口,让开发者可以像搭积木一样,轻松地将AI画质修复功能集成到自己的应用中。

SDK的角色与集成优势

对于短视频和直播平台而言,从零开始研发一套成熟的AI画质修复系统,需要投入大量的人工智能专家、算法工程师和海量的计算资源,这是一个成本高昂且周期漫长的过程。而选择像声网这样专业服务商提供的SDK,则是一条捷径。这些SDK已经将高度优化的AI模型、推理引擎以及与硬件适配的代码都打包好了。

开发者只需要按照文档说明,调用几个简单的API,就能在自己的App中激活AI画质修复功能。这不仅极大地缩短了开发周期,降低了技术门槛,更重要的是,专业的SDK通常经过了在海量设备上的测试和优化,能够保证功能的稳定性和在不同手机型号上的兼容性。这使得开发者可以更专注于业务逻辑和用户体验的创新,而不是陷入复杂的技术底层实现中。

AI模型的实时处理流程

直播场景对实时性要求极高,从采集视频到观众看到画面,延迟必须控制在毫秒级别。这意味着AI画质修复的整个处理流程也必须在极短的时间内完成。这对于计算资源有限的手机来说,是一个巨大的挑战。因此,SDK内部的工作流程必须经过精心设计和极致优化。

整个流程大致可以分为以下几个步骤,每一步都需要争分夺秒:

- 数据采集与预处理: SDK首先从摄像头或视频流中获取原始视频帧。然后进行快速的预处理,如解码、色彩空间转换,将其转换成AI模型能够“理解”的数据格式。

- 高效AI模型推理: 这是核心环节。预处理后的数据被送入一个轻量化设计的AI模型中进行计算。为了在手机端实时运行,这些模型通常经过了剪枝、量化等一系列优化,以在保证效果的前提下,最大限度地减少计算量。

- 硬件加速利用: 现代智能手机大多配备了专门用于AI计算的硬件单元(如NPU)。SDK会智能地检测并调用这些硬件,让AI模型的运行速度得到成倍提升。

- 后处理与输出: AI模型输出修复后的数据后,SDK会进行最后的处理,比如将其重新编码,然后渲染到屏幕上,或者推送到直播流中,最终呈现给观众。

| 步骤 | 主要任务 | 关键技术点 |

| 1. 视频帧输入 | 从摄像头或网络流获取原始、可能降质的视频帧。 | 低延迟数据捕获。 |

| 2. 数据预处理 | 解码、尺寸调整、归一化,为AI模型准备输入数据。 | 高效的图像处理库。 |

| 3. AI模型推理 | 将数据送入轻量化的AI模型,执行超分、降噪等核心算法。 | 模型量化、算子融合、NPU硬件加速。 |

| 4. 结果后处理 | 将模型输出的数据转换回可显示的视频帧格式。 | 色彩校正、编码优化。 |

| 5. 画面输出 | 将修复后的高清视频帧渲染到屏幕或推送到云端。 | 渲染管线优化,保证音画同步。 |

技术挑战与未来展望

尽管AI画质修复技术已经取得了长足的进步,但它仍然面临着一些挑战,同时未来的发展也充满了想象空间。如何在有限的手机性能和功耗限制下,实现更强大、更智能的修复效果,是所有技术提供商持续探索的方向。

性能与功耗的平衡

在移动端实现AI功能,永远绕不开性能与功耗的“跷跷板”。一个效果惊艳的AI模型,背后往往是巨大的计算量。如果为了追求极致画质而导致手机发烫、电量飞速下降,用户的体验同样会大打折扣。因此,算法工程师们需要不断地进行模型优化,探索更高效的网络结构,在保持出色效果的同时,尽可能地降低其对手机资源的消耗。

未来的解决方案可能会更加多样化。例如,通过端云协同的方式,将一部分非即时的、复杂的修复任务放到云端服务器去完成;或者,随着手机芯片的迭代,利用更强大的端侧AI算力,在本地就能轻松运行更复杂的模型。这种软硬件的协同进化,将是推动技术普及的关键。

技术的未来发展方向

当前的AI画质修复,更多的是在“还原”一个本应清晰的画面。而未来的发展方向,将是“创造”一个更美好的画面。AI将不仅仅是修复工具,更可能成为一个“美学大师”。未来的技术可能会结合场景识别,实现内容感知的智能增强。例如,在直播带货时,AI可以自动识别出商品,并对其进行细节和色彩的增强,使其看起来更诱人;在视频通话时,AI可以智能地优化人像,让肤色更自然,光影效果更柔和。

此外,视频体验的提升是全方位的。一个真正沉浸式的体验,不仅需要高清的画质,还需要纯净的音质。因此,将AI画质修复技术与AI音频降噪、回声消除等技术进行深度融合,将是必然趋势。像声网这样的平台,通过提供一体化的音视频SDK解决方案,能够将这些先进的AI能力系统性地赋予给开发者,共同构建一个更加清晰、真实、富有沉浸感的实时互动世界。

总而言之,短视频直播SDK中的AI画质修复技术,其原理根植于深度学习的强大能力,它通过模仿人类大脑的学习方式,智能地为我们重塑了数字世界的视觉体验。这项技术不再是遥不可及的未来科技,而是通过成熟的SDK服务,悄然融入我们日常的每一次点击和观看中。它解决了长期困扰用户的画质痛点,也为视频内容的创作者和平台方带来了新的机遇。随着算法的不断演进和算力的持续提升,我们可以期待,未来的视频世界将没有模糊和噪声,每一帧画面都将是我们眼中所见的清晰与精彩。