Granary 是 NVIDIA 于 2025 年8月推出的超大规模开源语音数据集,汇集了约 100 万小时的语音音频,覆盖25种欧洲语言。它是迄今最大规模的多语言语音数据资源之一,包括约65万小时的语音转录数据和35万小时的语音翻译数据。本文将详解 Granary 数据集的构成和制作方法,介绍其利用自动化“伪标注”管线高效生成高质量语音转录和翻译数据的过程,并解析基于 Granary 训练的两个模型——高准确率的 Canary 和高吞吐量的 Parakeet。

NVIDIA发布了开源的多语言语音 AI 数据集与模型

全球7000余种语言中,只有极少数主流语言得到了语音识别和翻译模型的良好支持。尤其在欧洲,多语环境复杂,欧盟有24种官方语言,另有多种地区语言和少数民族语言。然而,以往的语音AI系统对英语、法语、德语等大语种表现尚可,对克罗地亚语、爱沙尼亚语、马耳他语这类较小语种则往往缺乏训练数据,导致识别准确率很低。这种“数据鸿沟”限制了AI技术在多语环境下的应用,也使得某些语言社群在数字时代处于劣势。

为了建设更包容的多语言语音AI生态,研究界和产业界开始重视开源多语言语音数据的价值。如果能创建覆盖广泛语言且规模巨大的公开数据集,开发者就可借此训练模型,填补小语种数据不足的短板。以往已有Mozilla Common Voice等开源项目尝试通过众包收集多语言语音,但其规模和质量距离训练高性能模型尚有差距(例如Common Voice截至2025年仅收集了约33,000小时语音,分布在百余种语言中,平均每种语言数据量不大)。在此背景下,NVIDIA 联合学术机构发起了 Granary 项目,以期大幅提升多语言语音数据的规模和质量。

NVIDIA 的出发点很明确:用创新手段解决数据稀缺问题。他们选定欧洲语言作为切入点,集中构建一个覆盖25种语言的语音数据集。这25种语言包括欧盟官方的23种语言以及乌克兰语和俄语。许多语言(如克罗地亚语、马耳他语、爱沙尼亚语等)在过去几乎没有大型开放语音数据库。Granary 项目的目标不仅是收集数据,更要验证一种高效低成本的数据制作流程,从而为今后拓展到更多语言提供范例。

由此,Granary 数据集于2025年8月正式发布,并在当年的 Interspeech 国际会议上发表了论文。它成为首个在如此大规模上同时提供语音转录(ASR)和语音翻译(AST)数据的开源项目。接下来,我们将首先介绍 Granary 数据集本身的概况,然后深入解释它背后的数据构建方法和技术创新。

Granary 数据集概览

Granary 数据集的名字取自英文“谷仓”(Granary),寓意为一个储存丰富“粮食”(数据)的仓库。顾名思义,Granary 的规模极为可观:总计约 100 万小时的语音数据,其中包含将近 65 万小时用于语音识别训练的音频转录(ASR)数据,以及超过 35 万小时用于语音翻译训练的音频翻译(AST)对数据。这一规模远超此前任何公开的多语言语音数据集,使 Granary 成为名副其实的“大粮仓”。

Granary 覆盖了25种语言,几乎囊括了欧洲主要语言。根据论文中的列表,这25种语言包括:英语、法语、德语、意大利语、西班牙语等欧洲大语种,以及保加利亚语、捷克语、丹麦语、希腊语、爱沙尼亚语、克罗地亚语、匈牙利语、立陶宛语、拉脱维亚语、马耳他语、荷兰语、波兰语、葡萄牙语、罗马尼亚语、斯洛伐克语、斯洛文尼亚语、瑞典语等欧盟官方语言,再加上俄语和乌克兰语。可以看到,其中不乏传统意义上的低资源语言。Granary 选择聚焦欧洲语言,一方面是因为欧盟内部存在将近30种工作语言,对多语种AI有现实需求;另一方面欧洲语言之间有一定相似性(印欧语系为主),在技术上有利于多语言联合学习。

数据内容方面,Granary 的组成比较特殊。它并非人工录制或转写的数据集,而是运用算法从公开来源中“挖掘”而来。简单来说,团队收集了大量未标记的原始音频,然后通过自研的流水线自动生成了这些音频的文字转录和翻译,从而得到训练所需的对。正因如此,Granary 的开发无需耗费高昂的人力去听写翻译百万小时的语音,这在传统上几乎是不可能的任务。这套自动化管线由 NVIDIA 与卡内基梅隆大学、意大利 Bruno Kessler 基金会(FBK)的研究者合作开发,是 Granary 项目的核心创新之一。稍后我们将详细介绍其工作原理。

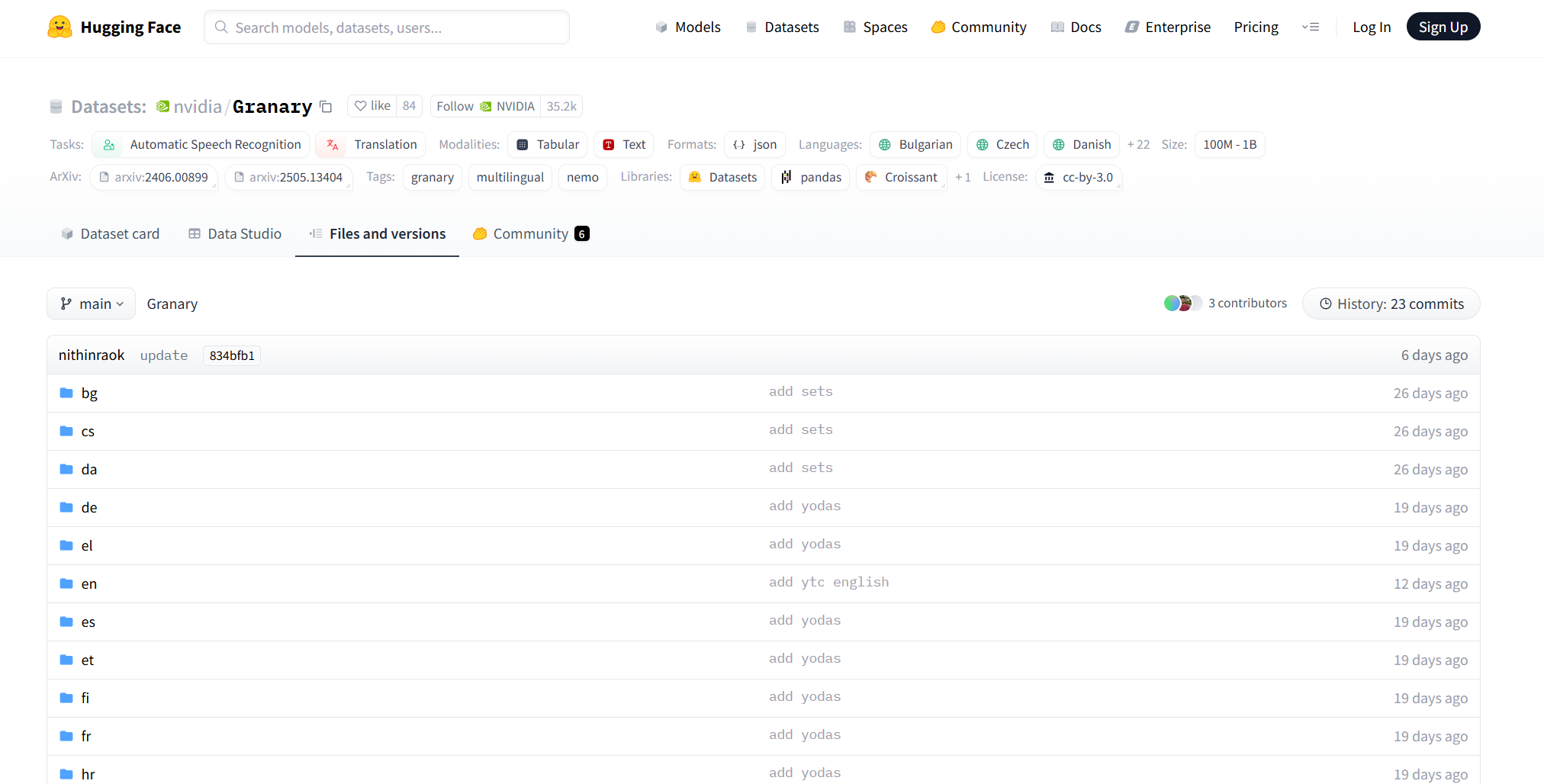

Granary 数据集已经通过 Hugging Face 平台向公众开放。任何研究人员或开发者都可以免费下载使用。这对于学术界和中小型企业来说意义重大:许多以往无法负担数据采集的小语种语音研究,现在因为 Granary 的出现有了用武之地。同时,Granary 也附带了详细的文档和质量评估报告。在 Interspeech 发表的论文中,团队展示了用 Granary 训练的模型在多语言语音识别和翻译任务上的效果,只需用 Granary 一半规模的数据就能达到过去需要整倍数据才能实现的准确水平。这说明 Granary 提供的数据相当优质,高效利用了数据中的信息。

Granary 并不仅仅是数据集本身,还包括一整套开源工具链。NVIDIA 将他们开发的数据处理流水线在 GitHub 上公开。这意味着他人可以重现 Granary 的数据生成过程,甚至将相同方法应用到别的语言集合上。这种开放性体现了项目的初衷:不仅提供数据“粮食”,还提供生产“粮食”的方法,希望社区共同改进并扩展。这种模式有望催生更多地区性的“大粮仓”数据集,比如将来或许出现面向非洲、亚洲多语言的类似数据集,加速全球范围内多语言语音技术的均衡发展。

总的来说,Granary 数据集在多语言语音AI领域具有里程碑意义。它以开源的方式提供了前所未有的大规模多语言语音/翻译数据,为研究者和开发者解除数据匮乏的掣肘。下面我们深入Granary背后的数据构建方法,看看团队是如何在无需人工逐条标注的情况下,打造出百万小时级别高质量数据的。

数据构建方法

Granary 数据集的制作高度依赖于自动化的伪标注(pseudo-labeling)管线。这个管线可以理解为由一系列算法模块组成的流水线,将原始的音频原料“加工”成带转录和翻译标注的成品数据。整个过程主要分为两部分:先针对语音识别(ASR)任务生成音频对应的文字转录,其次针对语音翻译(AST)任务生成音频对应的翻译文本。以下我们分别介绍这两部分的流程和关键技术。

语音转录伪标注管线

原始数据来源: Granary 原始音频数据来自多个公开的大型语音语料库。论文指出主要利用了三个来源:YouTube字幕语料YODAS、YouTube-Corpora (YTC),以及一个名为 MOSEL 的数据集。简而言之,这些语料都是通过网络平台获取的大规模音频和其自带的文本(如自动字幕、上传者字幕等)。例如,YODAS涵盖了超过100种语言、总计约50万小时的YouTube音频,其文本来自YouTube上的自动字幕或用户上传字幕;YTC也是类似的YouTube字幕数据,但其数据分布极不均衡,英语占了70%;MOSEL 则包括 VoxPopuli(欧洲议会多语音频)和 LibriLight(英文有声读物无标签音频)两个部分,文本是通过先前研究用 Whisper 模型自动转录得到的。

这些原始数据虽然量大,但存在各种问题:字幕转录质量良莠不齐、有的段落缺失或错误,语言标签不准确(例如一段音频标称法语但实际夹杂英语)等。因此,直接使用会导致模型学到噪声信息。Granary 团队没有简单拼接这些数据,而是设计了一套精细的处理流程来净化和完善它们。

- 步骤1:长音频切分 (Segmentation)。很多音频(尤其是来自YouTube或LibriLight的有声书)时长很长,一个文件里可能包含许多句子甚至多种语言。为了生成准确的句级转录,必须先把长音频切分为合理的小段。Granary 管线通过多种手段实现切分:对于有字幕的YouTube数据,采用强制对齐算法(如VAD语音活动检测、NVIDIA NeMo Forced Alignment工具等)将音频与已有字幕时间戳对齐,从而定位每句话的边界。对于没有现成时间戳的音频,则使用语音识别模型(Whisper或NVIDIA自家的Parakeet模型)生成初步转录和时间戳,再据此划分段落。切分的目标是在不漏掉内容的前提下,将每段控制在约几十秒内,Granary 设定最大不超过40秒。在实验中,团队发现两阶段切分效果较好:先用算法粗切,再用ASR模型重新跑一遍细调,从而获得更准确的切分和转录。例如,他们提到用 Whisper 给 YODAS/YTC 数据打上初始时间戳,再用 Whisper 进行第二遍推理以完善切分的内容。这个策略能补齐一些像 MOSEL 数据中字幕截断的问题。

- 步骤2:两遍识别 (Two-Pass Inference)。获得切好段的音频后,下一步是用语音识别模型转写成文字。Granary 选用了 OpenAI 的 Whisper-large-v3 模型作为主要的转录工具。Whisper 是多语种模型,但直接应用也有挑战:它对低资源语言准确率不高,且有时会“幻听”输出不存在的话。为此,Granary 管线采用“两遍识别”策略。第一遍先让 Whisper 判断音频段属于什么语言,然后第二遍在识别时将这一语言信息作为已知条件输入,从而提高转录准确率。Whisper 模型本身可以自动检测语言,但其检测可能出错或在多语混杂段落不稳定,因此团队在第一遍检测后还加入了语言ID验证步骤:如果 Whisper 预测的语言与该段所属目标语言不符,就将该段剔除不用于训练,防止错误标签影响模型。例如,VoxPopuli数据中常有现场译员翻译,导致一段音频出现两种语言,这种情况下Granary会检测到多个语言掺杂并加以过滤。此外,为减轻 Whisper 在嘈杂/静音部分产生幻觉的倾向,管线中集成了 Silero VAD(语音活动检测)。VAD 能识别音频中真正有说话的片段,Granary 在推理时只对检测到有语音的区间调用 Whisper,并在边界加上400毫秒余量防止截断。这样可以跳过安静片段,避免模型在无声处输出垃圾文本,也减少长静音导致的截断错误。经过两遍识别、语言核验和VAD过滤,多数明显的转录错误和不相关内容都被清理掉。

- 步骤3:文本清洗与标点恢复。Whisper 输出的转录文本通常是不带标点和大小写的(所有字母小写、无句号逗号),而阅读和后续翻译训练需要规范的文本格式。Granary 在得到初步转录后,使用了一个LLM(大型语言模型)来为文本添加标点和正确的大小写格式。文中称之为“PnC Restoration”(Punctuation and Capitalization Restoration),这是一个有趣的创新。具体做法可能是利用像 GPT-3 之类的语言模型或专门训练的模型,根据上下文语义推断该加的标点符号和大写专有名词等。这一步可以极大提高转录文本的可读性和准确性。例如,“thank you very much madam colleagues our debate is closed”会还原成“Thank you very much, Madam. Colleagues, our debate is closed.”。这种后期润色确保了转录文本接近人工制作的字幕质量。

- 步骤4:数据过滤。在上述过程中,其实已经穿插进行了多轮过滤,比如语言不符的段落、含多语言的段落、明显不完整的转录等都被剔除了。此外,Granary 还根据一些质量度量(如识别置信度、转录文本与原字幕对比等)进一步过滤掉低质量样本。经过所有处理,原始超过105万小时的音频最后保留下来的高质量转录音频约为643,237小时,总体保留率约60.7%。各语料来源的过滤比例有所不同:YODAS由于字幕噪声大,只保留了约52.9%(36万小时变19万小时;YTC仅处理了一部分也保留约47.9%;MOSEL质量相对好,保留约74.6%。最终汇总得到每种语言都有数千到数万小时不等的转录数据,极大丰富了这些语言的语音资源。

语音翻译数据生成

有了源语言的转录文本,Granary 还进一步生成了语音翻译对,即音频和其对应的另一种语言翻译文本。具体而言,由于聚焦欧洲语言,Granary 主要生成的是非英语音频 → 英语文本翻译,以及英文音频 → 目标语言文本的翻译数据。这样训练出来的模型可以胜任语音翻译任务,例如将法语语音翻译成英文,或将英文语音翻译成法文。

生成翻译的流程是:对每一段已经转写出的源语言文本,使用一个强大的机器翻译/大语言模型将其翻译成目标语言文本(多数情况下目标语言是英文,源语言是那25种语言之一;对英文音频则翻译成25种语言之一)。传统方法可能是训练一个专门的神经机器翻译模型完成此任务,但Granary 团队另辟蹊径,利用现有的多语种大型语言模型(LLM)来做这一翻译生成。这大大节省了时间和计算成本。

他们评估了多种可用的模型,包括一些开源的大型模型如阿里达摩院的 Qwen-7B、开源社区的 Alma-13B、以及他们与合作者训练的 EuroLLM-9B 模型等。在比较了在 Flores 多语言翻译基准上的表现后,团队选定 EuroLLM 9B 模型作为主要的伪翻译生成工具。EuroLLM 9B 是一个针对欧洲语言优化的9亿参数的语言模型,在多语言翻译任务上效果最佳。接下来,他们采用该模型对每条源语言转录执行推理,生成对应的英文翻译文本(或英文转录生成多语言翻译)。为提高效率,翻译时使用贪心解码且借助 vLLM 加速,确保在庞大数据量下能快速产生结果。他们也尝试过beam search等方法略微提升翻译质量,但发现对9B模型而言收益不大且耗时增加,最终选择了速度更快的方案。

翻译后过滤: 自动翻译难免有错误或不符合语境的地方,尤其LLM有时会“幻译”或产出风格不一致的句子。为此,Granary 同样设计了质量评估和过滤步骤。他们使用了一套质量估计模型或规则,过滤掉可能存在翻译谬误的样本。例如,如果某条翻译看起来与源语言内容不相干,或包含LLM编造的内容,就将其剔除。通过这一系列流程,最终 Granary 获得了超过 35万小时的语音翻译对数据。这意味着,对于那25种语言的大部分音频,Granary 都提供了与其对应的英文译文(以及相应部分英文音频对应的多语译文)。如此规模的多语言语音翻译数据在业界尚属首次开放。

整个管线充分利用了 NVIDIA 强大的计算资源,实现了高效处理。团队表示,这套流水线可以在数小时内处理庞大的数据量。例如,通过并行化,几百上千小时的音频数据在短时间内即可完成切分、转录、翻译的全流程。这种效率让百万小时的数据制作成为可能——如果靠人工听写翻译,百万小时音频几乎无法在现实时间内完成,而有了AI和GPU的助力,一切变得可行。

通过以上步骤,Granary 数据集得以成型。从无序、带噪声的网络音频到结构化、高质量的语音-文本对,Granary 团队的自动化管线功不可没。这套方法的成功也为未来扩展到其他语言提供了借鉴:只要有大量未标记音频,我们就可以用类似方法进行大规模伪标注,而不必完全依赖人工。这标志着语音AI训练从“数据匮乏”走向“数据自给”的新阶段。

基于 Granary 的模型

有了 Granary 这样丰富的训练数据,NVIDIA 随即训练并发布了两款有代表性的多语言语音模型,即 Canary-1b-v2 和 Parakeet-tdt-0.6b-v3。这两款模型分别针对不同的应用需求进行了优化:一个追求最高的转录准确率,另一个侧重实时性和长音频处理能力。它们都是在 Granary 数据上训练的开源模型,对开发者极具参考价值。下面分别介绍其特点。

Canary-1b-v2:高精度多语种模型

Canary-1b-v2 是 NVIDIA 基于 Granary 数据训练的旗舰语音模型,拥有约10亿参数。正如其名(Canary, 金丝雀)给人的灵敏印象,Canary 模型追求的是高准确率。它支持25种欧洲语言的语音转录,并可在英文和这两打语言之间进行语音翻译。也就是说,Canary 不仅能将法语语音转写成法语文本,也能直接翻译成英文文本,功能十分强大。根据 NVIDIA 公布的信息,Canary-1b-v2 在 Hugging Face 的开源多语言语音识别排行榜上名列前茅,是当前准确率最高的开源模型之一。

Canary 模型在保持高性能的同时,规模远小于同等准确率的其他模型。Canary-1b-v2 在转录和翻译质量上可媲美参数量大三倍的模型,但推理速度却快了十倍左右。这表明 Granary 数据的高效和模型架构的优化,使得小体量模型也能发挥大模型的效果。推测其背后原因,可能是Granary数据质量高且涵盖了丰富的口音和用法,模型不用“浪费”参数去学习噪声或纠错,因此表现更佳。Canary-1b-v2 还采用了优化的解码和并行策略,以实现在保证精度的同时大幅提升推理吞吐量。

在 Granary 项目之前,NVIDIA 就曾发布过 Canary 模型用于语音识别,但仅支持4种语言。而 Canary-1b-v2 将语言扩展到25种,实现了质的飞跃。随着语言增加,模型训练难度提高,但凭借Granary的数据,Canary 成功做到了“多而精”。

NVIDIA 将 Canary 模型在 Hugging Face 上开放,并采用宽松的许可证(如 CC-BY 等)发布。这意味着开发者可以自由将它应用于研究和商业项目中。一个拥有顶尖精度的开源多语种ASR/翻译模型,对于需要多语言交互的企业(如全球呼叫中心、国际化产品)来说价值巨大。他们可以通过微调 Canary 来适配特定领域,而无需从头训练一个庞大模型。

总而言之,Canary-1b-v2 证明了 Granary 数据的威力——在高质量大数据支持下,中等规模的模型也能达到领先水平。它为多语言语音AI设立了一个新的标杆:不一定要最大的模型,数据充分且干净同样能换来优异表现。

Parakeet-tdt-0.6b-v3:高速转录模型

Parakeet-tdt-0.6b-v3(鹦鹉模型)是与 Canary 相辅相成的另一款 Granary 系列模型。Parakeet 模型约有6亿参数(比Canary小一半左右),设计目标并非极致精度,而是极致速度和长音频处理能力。

Parakeet-tdt 模型名称中的 “tdt” 代表 “Time-Dependent Transducer”(时间延迟转录)或类似含义,暗示了它针对长时段音频转录进行优化。NVIDIA 表示,Parakeet-tdt-0.6b-v3 是当前 Hugging Face 平台吞吐量最高的多语言语音转录模型。吞吐量指的是单位时间内处理的音频时长。在评测中,Parakeet 模型每处理1秒钟音频只需要远少于1秒的计算时间,达到了实时甚至超实时的水平。相比之下,一些大模型可能需要数倍于音频时长的时间来运算,难以用于实时应用。因此 Parakeet 十分适合需要高速转录的场景。

另一个亮点是,Parakeet-tdt 模型能够在单次推理中处理长达24分钟的音频,而不需要将其切成小段。这是非常罕见的能力。许多语音识别模型为了控制计算,通常对输入音频长度有限制(比如几分钟以内),长音频要切片后分段识别,再拼接输出。Parakeet 则省去了这种繁琐,直接就能对一场数十分钟的演讲或一集播客做整段转录。这得益于其架构和Granary数据训练,使模型能够处理长上下文而不崩溃或遗忘前面内容。同时,Parakeet 模型内置了自动语言检测功能:无需用户指定语言,模型会自动判断输入音频说的是什么语言,并给出对应转录。对于多语言混杂的长录音,它也能分别转写不同部分的内容,充分体现智能性。

虽然 Parakeet 模型牺牲了一定的精度(相较 Canary),但它的识别准确率在Granary数据支持下依然相当可观,并附带优美的输出格式——自动加上标点和大小写,就像人工打好的逐字稿一样。这使得Parakeet的转录结果可以直接被阅读或用于字幕,而无需再处理。

针对 Parakeet 模型的应用场景,可以举几个例子:媒体字幕生成——将长视频音轨一键转录成带时间戳的字幕;电话中心质检——实时转录多语言电话录音,分析内容;会议记录——在跨国会议中实时识别不同语言的发言并记录。不论是离线大批量处理还是在线实时服务,Parakeet 模型都表现出色。这类高吞吐量模型为实用化落地提供了可能。

Canary 和 Parakeet 模型都已经在 Hugging Face 上提供,并附有示例和文档。开发者可以根据自身需求选择使用:追求最高准确率的用 Canary,追求实时性的用 Parakeet,或者结合两者取长补短。例如,先用 Parakeet 快速转录,再用 Canary 校对修正关键片段,以兼顾速度和精度。

通过 Canary 和 Parakeet,我们看到了 Granary 数据驱动下模型能力的全面提升:不仅准确率登顶,实用性能如速度、长时处理也获得重大突破。这两者的搭配证明了开放数据与模型优化的巨大潜力。

Granary 的价值与意义

Granary 数据集和其衍生模型的推出,在多语言语音 AI 领域引起了强烈反响。它所带来的价值和意义可以从以下几个方面来理解:

1. 弥补低资源语言数据鸿沟,推动技术公平。 Granary 首次为许多欧洲低资源语言提供了大规模高质量的语音训练数据。像马耳他语、克罗地亚语、爱沙尼亚语等语言,以往由于缺乏数据,语音识别性能长期停滞。Granary 的出现为这些语言带来了希望。研究者和开发者现在可以直接使用 Granary 数据训练模型,开发针对这些语言的语音应用,而不必从零开始收集数据。这对保障说这些语言的群体在AI时代不被边缘化具有重要意义。

2. 新的高效数据制作范式。 Granary 项目展示的伪标注流水线是一种可扩展、可复用的数据制作范式。它证明了利用强大的预训练模型(如Whisper、LLM)和精巧的算法,可以在无人工参与下生产出规模巨大的标注数据,而且质量足以媲美人工标注。这打破了传统观念中“大数据=高成本”的壁垒。未来,其他研究团队可以借鉴Granary的流水线,将其应用到更多语言上。例如,可以针对非洲语言、中亚语言等执行类似的伪标注流程,只要有足够的原始音频来源即可。这种方法通过代码和模型共享,很容易被社区采用,从而掀起开放语音数据集的浪潮。Granary 已将其流水线开源,鼓励研究者改善和移植。

3. 降低行业进入门槛,加速应用创新。 有了 Granary 数据和 Canary/Parakeet 这类开源模型,中小型企业、初创团队也能快速进入多语言语音应用领域。他们无需投入巨资采集数据、训练超大模型,只需利用现成资源进行适配和开发即可。这将大大加快语音AI在各垂直行业的落地创新。开发者现在可以更容易地将 AI 应用扩展到全球用户,提供快速、准确的多语言语音技术服务,例如多语聊天机器人、客户服务语音座席、实时翻译等。

4. 推动研究进步,促进学术开放。 从学术角度看,Granary 开放了一个研究新天地。以往,多语言语音识别和翻译的研究受到数据限制,很难进行统一评测或对比。现在,有了统一的百万小时级数据,研究者可以在更大舞台上验证算法想法。例如,可以研究如何在同等数据规模下进一步提升模型效率,或者比较不同模型在25种语言上的泛化表现。这些都有助于我们更深入地理解多语言学习的规律。此外,Granary 作为首个大规模开源语音翻译数据集也填补了学术空白。过去语音翻译数据非常稀少,Granary 提供了宝贵的训练/测试资源,预计会诞生许多围绕语音翻译的新研究成果。更棒的是,Granary 的完全开源和透明流程符合可重复科研的原则。研究人员能够准确了解数据从何而来、经历怎样处理,这对于分析模型行为、提高可解释性都有帮助。

5. 商业与社会影响: Granary 数据集将直接或间接地带来商业和社会效益。商业上,拥有广泛语言覆盖的语音AI产品将层出不穷,服务更多语种市场,带来新的经济增长点。社会上,多语言语音技术的普及有利于非通用语种文化的数字存续

当然,我们也应看到Granary目前的局限:其覆盖语言主要为欧洲语言,对其他语系语言尚未涉及;利用自动管线产生的数据可能存在系统性偏差,需要持续改进模型来消除;另外开源数据虽好,但体量巨大,普通团队训练模型仍需相当算力投入。不过,Granary 已提供了一个坚实起点。后续完全可以有针对性地扩充数据(比如加入亚洲语言的子集),以及与Meta MMS等项目结合,进一步完善多语言语音生态。

结语

Granary 开源语音数据集的问世,以创新的方法成功聚合了百万小时级别的多语言语音和翻译数据,并向全球开放。这不仅在技术上证明了大规模伪标注的可行性,更在实践中为弱势语言赋能,让更多语言有机会进入人工智能的版图。对于多语言语音 AI 的未来,Granary 带来了几点重要启示:首先,大模型和大数据并不矛盾,好的数据能让相对紧凑的模型也发挥卓越表现,这提示我们应更加重视数据质量和高效利用。其次,自动化、智能化的数据生产将成为趋势,人机协同将加速AI资源的累积。再次,开源共享会形成良性循环,数据和模型的开放促成更快的技术进步和应用落地。

总而言之,Granary 开源语音数据集为构建包容、多元的对话式人工智能迈出了坚实的一大步。它让我们离“AI for everyone”(惠及每一种语言和文化的AI)这一目标更近了一些。今后,随着更多类似资源和成果的涌现,多语言语音 AI 的星辰大海终将广阔无垠。