想象一下你正在和朋友聊天。当朋友说”我昨天去了…”然后停顿了一下,你会立刻插话吗?大概率不会,因为你知道这个句子还没说完。但如果朋友说完”我昨天去了公园”,然后沉默了,你就知道该你说话了。这种判断能力看似简单,但要让机器学会却相当复杂。基于IPU(Inter-Pausal Unit,间停顿单元)的模型,正是教会机器这种判断艺术的一种重要方法。

一. 什么是 IPU?

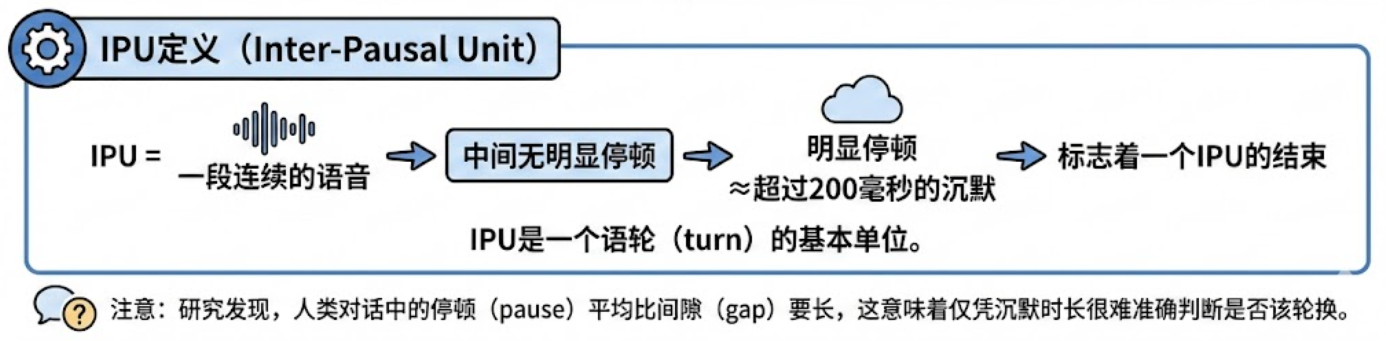

在深入了解IPU模型之前,我们先要理解什么是IPU。简单来说,IPU就是一段连续的语音,中间没有明显的停顿。这里的”明显停顿”通常指超过200毫秒的沉默。

举个生动的例子:

- “我想要……”[停顿 300 毫秒]“……一杯咖啡” (这是两个 IPU)

- “我想要一杯咖啡” (这是一个IPU)

IPU是一个语轮(turn)的基本单位。每当说话人停顿超过一定时长,就标志着一个IPU的结束。研究发现,人类对话中的停顿(pause,同一说话人的IPU之间的沉默)平均比间隙(gap,不同说话人之间的沉默)要长,这意味着仅凭沉默时长很难准确判断是否该轮换。

IPU定义图示

二. IPU 模型的工作原理

基于 IPU 的轮换模型,采用一种典型的 「先检测,再判断」 的策略。与传统“固定超时”方案(通常要等 700–1000 ms)不同, IPU 模型可以在 200–300 ms 内做出更精准的轮换判断。

第一步:检测 IPU 边界

系统首先使用语音活动检测器(VAD,Voice Activity Detector)来识别语音和沉默。当检测到超过200毫秒的停顿时,系统就知道:一个IPU结束了。

第二步:分析轮换线索

这是关键所在。系统不会简单地因为检测到停顿就认为该自己说话了。相反,它会分析多种线索来判断这个IPU结束是否真的意味着轮换(TRP,Transition Relevant Place):

语法完整性(Syntactic Completion)

根据 Ford 和 Thompson(1996)的定义,如果一个话语“在其语境中可以被理解为一个完整的子句”,那么它就是语法完整的:

- ✅ “我喜欢苹果” —— 语法完整,可能是轮换点

- ❌ “我想要一个……” —— 语法不完整,应该等待

- ✅ “明天” —— 虽然只是一个词,但在回答”什么时候见面?”时语法完整

韵律特征(Prosodic Cues)

研究表明,韵律在轮换判断中起重要作用:

- 音调:下降调或上升调通常暗示轮换,而平调暗示继续

- 音量:轮换点的音量通常较低

- 语速:句末拉长可能是轮换信号

语用完整性(Pragmatic Completion)

这是更深层的判断——话语是否构成了一个完整的对话行为:

- “我想要一个汉堡” + “配薯条” —— 虽然”配薯条”语法完整,但语用上是前句的延续

- “好的” —— 回应确认,语用完整

其他模态线索

在面对面交流中,还包括:

- 视线:说话人在句末看向听者暗示轮换

- 呼吸:呼气暗示结束,吸气暗示继续

- 手势:手势的完成通常与轮换点对齐

第三步:做出决策

基于这些分析,系统计算出一个”轮换概率”。研究表明,这些线索具有叠加效应——单个线索可能不够可靠,但多个线索的组合能大大提高判断准确性。

三. 实际应用案例

让我们通过一个餐厅点餐机器人的例子来理解IPU模型的实际应用:

场景一:处理思考停顿

场景二:识别真正的轮换

场景三:处理填充停顿

四. IPU 模型的优势与挑战

优势

- 反应更快:相比传统的固定超时模型(通常需要700-1000毫秒),IPU模型可以在200-300毫秒内做出反应。

- 中断更少:通过分析多种线索,大大减少了不恰当的打断。

- 对话更自然:让人机对话更接近人与人的交流。

挑战

- 依赖 ASR 准确率:如果语音识别出错,可能导致错误的轮换判断。

- 处理延迟:虽然比传统方法快,但分析各种线索仍需要时间。

- 个体差异大:不同人的说话习惯差异很大,模型需要有很强的适应性。

五. 技术实现细节

在实际系统中,IPU模型通常采用机器学习方法来整合各种线索:

经典方法

早期的IPU模型多采用传统机器学习方法:

- 决策树(Sato et al., 2002):基于语法、语义、对话状态和韵律特征,准确率达83.9%。

- 逻辑回归(Gravano & Hirschberg, 2011):发现文本完整性是最重要特征,其次是音质、语速和音量。

- 条件随机场(CRF):虑时序依赖关系。

深度学习方法

近年来,深度学习带来了显著提升:

- LSTM模型(Skantze, 2017)可以预测未来3秒的语音活动,实现真正的预测而非仅仅检测。

- Transformer模型(Ekstedt & Skantze, 2020)TurnGPT模型利用上下文信息,准确预测轮换概率。

多模态融合

研究表明,组合不同模态的线索能显著提高性能(Johansson & Skantze, 2015):

- 单独使用词汇特征:准确率约70%

- 加入韵律特征:提升至75-80%

- 加入视线信息:可达85%以上

六. 一个创新案例:基于现代 LLM 的纯文本 IPU 模型

在当前的三段式对话系统的设计中,ASR – LLM – TTS结构非常适合纯文本IPU模型。TEN Turn Detection项目展示了如何将IPU概念创新地应用到纯文本环境。

TEN 模型的设计理念

虽然没有语音停顿和韵律信息,TEN模型通过深度语义理解来判断”文本IPU”的边界。

三状态分类系统:

1. “finished”(完成):文本表达完整,对方可以回应

- “我想要一杯咖啡。”

- “会议改到明天下午三点。”

2. “unfinished”(未完成):明显未完成,需要等待

- “我想要一杯…”

- “会议改到…”

3. “wait”(等待):用户明确指示系统保持安静

- “等一下,让我想想…”

- “别说话,我在思考。”

- “稍等,我查一下资料。”

这种三分类设计特别实用。”wait”状态让系统能够识别用户的显式控制意图——当用户需要时间思考、查找资料或处理其他事务时,系统会保持安静而不是急于回应。这种设计体现了对真实对话场景的深刻理解。

技术实现示例

TEN模型基于Qwen2.5-7B大语言模型,通过以下方式补偿缺失的语音信息:

Python

示例:分析话语完整性

input: "我想点一个汉堡"

analysis: {

"turn_state": "finished"

}

性能表现

即使没有语音线索,TEN模型仍达到了优异的性能:

- 中文完成状态检测:98.90%准确率

- 英文未完成状态检测:98.44%准确率

- 等待状态检测:约92%准确率

这证明了通过强大的语言理解能力,可以在一定程度上弥补语音信息的缺失。

七. 未来展望

IPU模型的发展方向充满可能性:

技术演进

- 自适应学习:通过强化学习适应特定用户的说话习惯

- 增量处理:实时处理语音流,而非等待IPU结束

- 跨语言泛化:开发适用于多语言的通用模型

应用扩展

- 多模态对话系统:整合语音、文本、视觉信息

- 实时翻译:准确把握说话人何时结束,优化翻译时机

- 虚拟助手:更自然的人机交互体验

- 在线会议:智能静音和发言管理

版权声明:本文由作者授权上海声网科技有限公司发表。未经许可,不得转载。

本文内容为作者个人观点,仅用于技术交流与分享,不代表上海声网科技有限公司的官方立场或承诺。

如涉嫌侵权,请联系我们:blog@shengwang.cn

首页

首页