近日,声网受邀出席由极客邦科技旗下 TGO 鲲鹏会主办的“2025 GTLC 全球科技领导力大会”。在“软件新范式:AI 时代的重构与引领”论坛上,声网首席科学家、CTO 钟声以“日益高效协同的智能体系统”为主题进行了演讲,他从历史上信息的生成、传播与消费,衍生到 Agent 之间的协同模式,带来了技术和理论之间的融合思考。以下为现场演讲实录:

信息生成、传播与消费的效率日益提升

钟声认为,人类文明的进步史,本质是信息生成、传播与消费效率的跃迁史。早期信息传播靠口口相传,传播范围和数量很有限;及至文字出现后,较长时期仍受限于石刻、树皮、竹简等介质,记忆与传播范围仍很有限,信息也易失真失传;古腾堡印刷技术的发明,书籍成为传播介质,才极大释放了知识的力量,教育和知识才得以普惠更多民众,社会、人文和科学技术才有了极大的进步。这个阶段,书籍印刷数量、运输及销量难以准确把握,分发渠道成为瓶颈;直到互联网出现,内容分发几近成为零成本。此时,用户要找到自己需要的内容并不容易,门户网站所给内容有限,以 Google 为代表的搜索技术有效地解决了这个难点。可以随意搜索后,消费者发现内容供给不足了;随后网络技术进化到 Web 2.0 ,用户生成的内容大量涌现。此时,内容筛选成了难题。然后就出现了以 Facebook、抖音等为代表的公司以推荐算法来推送用户喜欢的精品内容。精品内容往往是由大V、网红、名师来生产,此阶段平台维护大 V、网红、名师的成本很高,近年来生成式 AI 技术的进步,可以有效降低精品内容生成的成本,大V、网红、名师也可以通过 AI 分身/ Agents 的方式来复刻,甚至每个普通用户也可以有 AI 分身/ Agents, 这样可以在众多功能各异的“ Agent to Agent ”的协作和互动中,帮助用户解决大量问题,开启信息传播的智能时代。

综上,我们发现一个规律:效率提升的关键在于消除重要环节上的“摩擦力”。而当 ChatGPT 掀起生成式 AI 浪潮后,Agent 之间协作的效率将值得关注。

更高效的信息表示、交互协议和基础设施 可以提升 LLM / AI Agent 能力和效率

就目前的大多数 AI Agent 系统而言,大模型解决问题的能力还需提高、算力消耗依旧很高。这成为当前 AI Agent 推广应用面临的摩擦力。我们尝试从信息表示、交互协议、基础设施的角度来分析如何减少这些摩擦力。

Token 是大语言模型 LLM 信息表达的基本单元,之后 Token 转换为抽象的 Embedding,再参与注意力计算。去年5月,DeepSeek V2 提出 MLA(Multi-Head Latent Attention)多头潜在注意力机制,以更抽象更简约的表示减少 KVcache 显存占用,并同时提升了在算力限制下模型的能力,加上其稀疏混合专家模型算法,为开源大语言模型建立了新范式。

钟声认为,AI Agent to Agent 的协议需纳入任务复杂度的描述;同样 LLM / Agent 能力也需要更明确的描述。这样才能有效实现任务与模型/ Agent 的精准适配,避免模型 “高配造成浪费” 或“低配造成任务得不到解决”。

近期的研究表明,对于某个数学问题,当基于 Claude3.5 的推理模型输出的推理 Token 数超 53 时,该数学任务在几乎所有提示词方式下都能得到正确解答;反之,当模型输出的推理 Token 数小于 53 时,该问题就得不到正确解答。这显示出任务存在着内涵的复杂度。

一个特定大语言模型的能力也存在上限。最近也有研究表明,随着输出推理 Token 数的增加,模型也越能解决更难的任务,但是当任务复杂度超过一定难度后,再增加推理 Token 数就于事无补了,做再多的推理也无法解决问题。而且,对于低复杂度任务,往往“非思考模型” 效率更高,能以更少的 Token 数解决问题。复杂任务需 “思考模型”做推理,但难度超模型能力上限均会失效。因此一个特定的模型也存在内涵的能力上限。AI Agent to Agent 的协议应该包含模型能力的描述,才能在多 Agent 协作中做任务编排时做到合理有效的匹配。

尤其在垂直领域,待执行的任务较为明确,这两项复杂度适配对保障任务高效完成至关重要。

LLM 模型能力和效率提升:巧用 COT 思考机制

钟声认为,COT 思考机制有助于提升大模型能力与效率,推理 Scaling Law 最近虽然被广泛应用,且带来了明确收益,但强化学习后训练和推理的代价高、计算量大。这其中会产生一个问题,一定参数量的大语言模型,它的能力上限具体是多少?怎么达到?所以,探索一定参数量下大模型能力上限及实现方式成为了大模型优化的一个重点研究方向,其中 DeepSeek 的算法与训练方法创新就是很好的案例,在参数受限下有效提升了模型能力。以后还会有更新更高效的算法出现。

应用层面,“思考” 与 “非思考” 模型结合成新趋势,思考模型并非适用于所有场景或问题;长短思考结合也可提升效率,融合两类思维链数据,能增强短思考模型的能力。

另外,AI Agent 的日益普及需要快准灵的垂类模型。垂域知识和数据是垂类 AI Agent 的关键,这类数据通常不是通用大模型可以覆盖的,而小模型经垂类数据优化后可兼顾效率与准确性。一般来说,在垂类场景(如数字销售、HR 面试、客服等)中通常需要类似真人对话般的低延时响应,如果较小的模型能专注解决垂问题,就可以在这些场景中带来低延时体验。

端边云结合的基础设施 是 AI Agent 系统必由之路

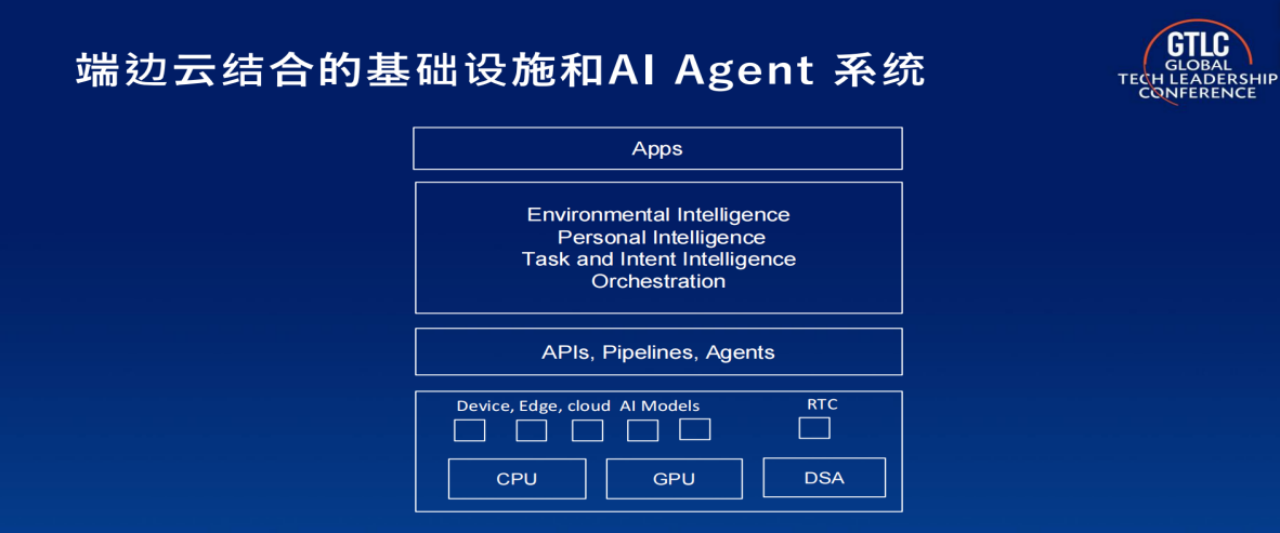

钟声还提出,大模型后训练和推理的算力需求激增,AI Agent 普及也需要快准灵的各种垂类模型,这些特点和趋势决定了端边云结合的基础设施是 AI Agent 系统必由之路。

当 AI Agent 系统利用端边云结合的基础设施时,智能化任务编排成为提升系统效率与保障用户体验的关键。从 AI Agent 与任务编排视角出发,底层的 CPU、GPU 及专用 AI 芯片,无论部署于端设备、边缘侧还是云端,都应服务于任务需求。理想的编排模式是依据任务难度,精准匹配最合适的 Agent 或者 LLM ,进而由合适的算力资源来做计算,实现任务级调度优化。例如,若手机端模型即可满足任务需求,由手机算力来做计算便能避免网络传输,有效规避网络抖动、延时等问题。

任务编排不仅涉及硬件资源调配,还需对用户意图及任务进行智能识别,并转化为可执行的操作。同时,用户个人偏好、网络状况、噪声、回声等环境变量,都会对系统运行产生影响。例如当处于高铁等网络易抖动和拥堵、信号弱的场景时,若强行进行大量数据远程传输,用户体验将大打折扣。因此,构建端到端丝滑流畅、低摩擦的系统,需全方位解决各环节问题,从而实现基于端边云基础设施的合理高效的 AI Agent 系统。

演讲最后,钟声还演示了由声网和 RTE 开发者社区支持的 TEN Framework 开源框架,并利用此框架实现的一个由 STT、LLM、TTS 、RTC 及降噪等模块组成的端边结合实时对话 AI Agent 。尽管现场观众规模超五百人,面临复杂的噪声、回声、麦克风延迟等困难,钟声与 AI Agent 的互动仍然表现出了优秀的对话能力,在普通 4G 网络环境下实现了流畅、自然、有趣的双向实时对话,对话模型的极快响应速度、及时打断与被打断的自然程度、对抗噪声能力、遵循语音指令做等待能力都非常突出。